SK hynix Paparkan Strategi dan Roadmap AI Memory Generasi Berikutnya di SK AI Summit 2025

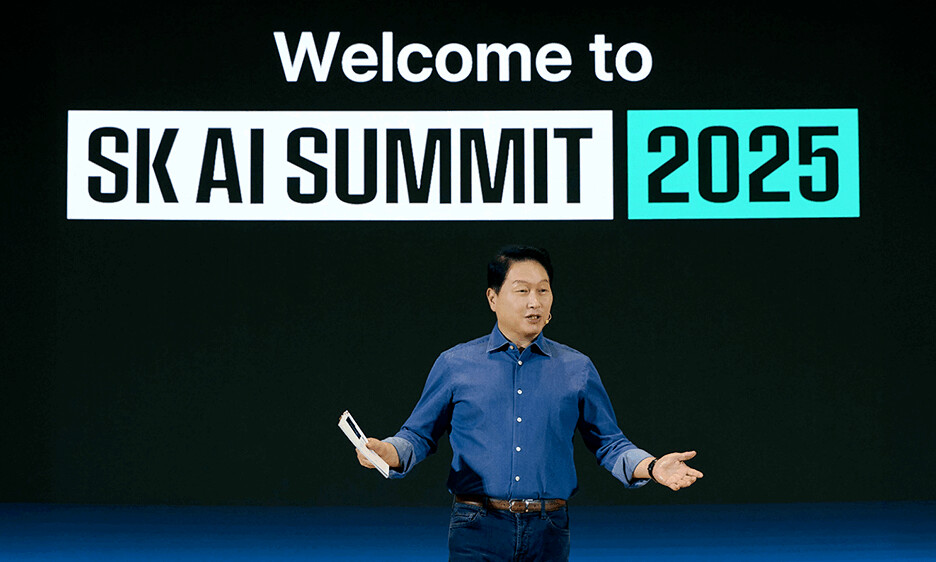

SK hynix memamerkan strategi memori AI generasi mendatang dan roadmap teknologinya pada ajang SK AI Summit 2025 yang digelar di Seoul pada 3–4 November. Dengan tema “AI Now & Next,” acara tahunan ini—yang sebelumnya dikenal sebagai SK Tech Summit—menghadirkan para pemimpin industri global untuk membahas kondisi AI saat ini serta arah masa depannya, termasuk aplikasinya di berbagai sektor.

Hadir dalam acara tersebut para tokoh besar seperti Chairman SK Group Chey Tae-won, CEO SK hynix Kwak Noh-Jung, serta CEO SK Telecom Jung Jaihun. Tokoh teknologi global seperti CEO OpenAI Sam Altman dan CEO Amazon Andy Jassy turut memberikan keynote melalui video. Perusahaan besar lainnya, termasuk NVIDIA, AWS, Google, TSMC, Meta, dan anggota aliansi K-AI dalam negeri, juga berpartisipasi untuk memperkuat kolaborasi ekosistem AI.

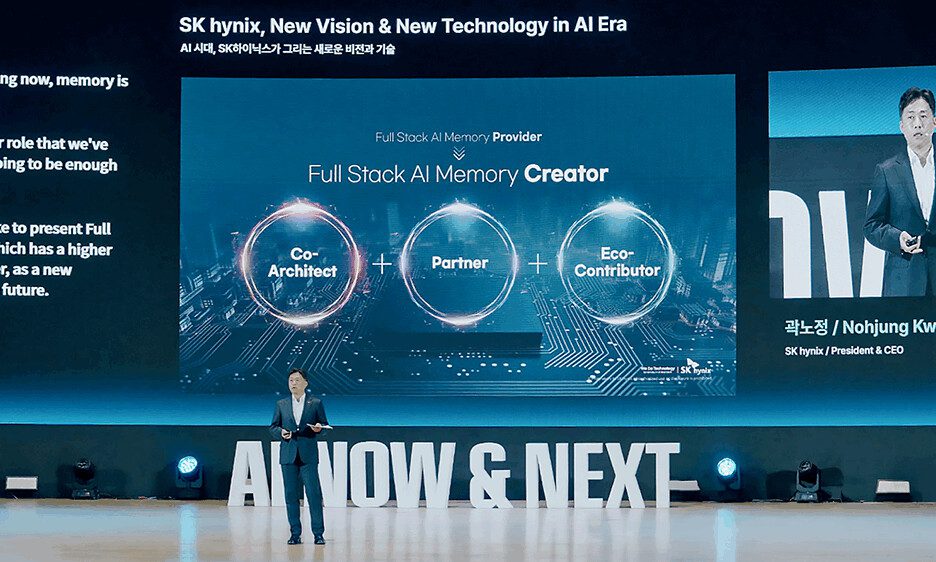

Evolusi Visi: Dari Penyedia Menjadi Pencipta AI Memory Full-Stack

CEO SK hynix Kwak menegaskan bahwa industri memori sedang memasuki fase baru, dipicu oleh kebutuhan data yang terus meningkat akibat perkembangan AI. Ia menjelaskan bahwa kecepatan memori kini menjadi hambatan besar (memory wall) karena tidak lagi sebanding dengan kemajuan prosesor.

Kwak menyampaikan visi baru SK hynix yang berevolusi dari sekadar full-stack AI memory provider menjadi full-stack AI memory “creator.” Tujuannya bukan hanya menyediakan produk, tetapi ikut memecahkan masalah pelanggan dan berkolaborasi membangun masa depan infrastruktur AI.

Ia kemudian memperkenalkan strategi memori AI penuh (full-stack) dengan tiga pilar utama:

1. Custom HBM (High Bandwidth Memory)

Dirancang untuk memindahkan sebagian fungsi komputasi dari GPU/ASIC ke base die HBM, meningkatkan efisiensi sistem secara keseluruhan, sekaligus mengurangi konsumsi daya transfer data—sejalan dengan pergeseran kebutuhan pasar AI menuju inference efficiency dan TCO yang lebih optimal.

2. AI DRAM (AI-D)

Lini DRAM tersegmentasi yang dikembangkan khusus untuk kebutuhan era AI:

- AI-D O (Optimization): DRAM hemat daya dan berkinerja tinggi seperti MRDIMM, SOCAMM2, LPDDR5R

- AI-D B (Breakthrough): Memori ultra-kapasitas seperti CXL Memory Module (CMM) dan PIM untuk menembus memory wall

- AI-D E (Expansion): DRAM seperti HBM untuk aplikasi robotika, mobilitas, dan otomasi industri

3. AI NAND (AI-N)

Solusi penyimpanan generasi berikutnya berkapasitas ultra-tinggi untuk sistem AI:

- AI-N P (Performance): SSD berkinerja ekstrem untuk inference skala besar, dirancang ulang dengan arsitektur baru; sampel hadir akhir 2026

- AI-N B (Bandwidth): NAND bertumpuk menyerupai HBM untuk bandwidth lebih luas

- AI-N D (Density): QLC NAND berkapasitas petabyte, menggabungkan kecepatan SSD dengan biaya mendekati HDD

Diskusi dan Kolaborasi Menuju Arsitektur Memory-Centric

Beragam sesi panel turut membahas kebutuhan mendesak akan arsitektur memory-centric untuk menghadapi bottleneck AI. Hoshik Kim (SVP Memory System Research) berdiskusi bersama pakar dari UC Berkeley, Stanford, Meta, dan MemVerge mengenai masa depan infrastruktur AI yang lebih efisien.

Presentasi lain dari Vice President Kyoung Park menyoroti evolusi AI dari cloud hingga edge, dengan memori yang kini menjadi faktor penentu performa sistem. Sementara itu, Vice President Youngpyo Joo menekankan pentingnya kolaborasi erat antara penyedia memori, vendor ASIC, dan arsitek sistem.

Profesor Kyusang Lee (University of Virginia) juga mempresentasikan teknologi konektivitas masa depan berbasis Co-Packaged Optics (CPO) dan sumber cahaya micro-LED untuk mengatasi keterbatasan bandwidth dan efisiensi energi interkoneksi listrik tradisional.

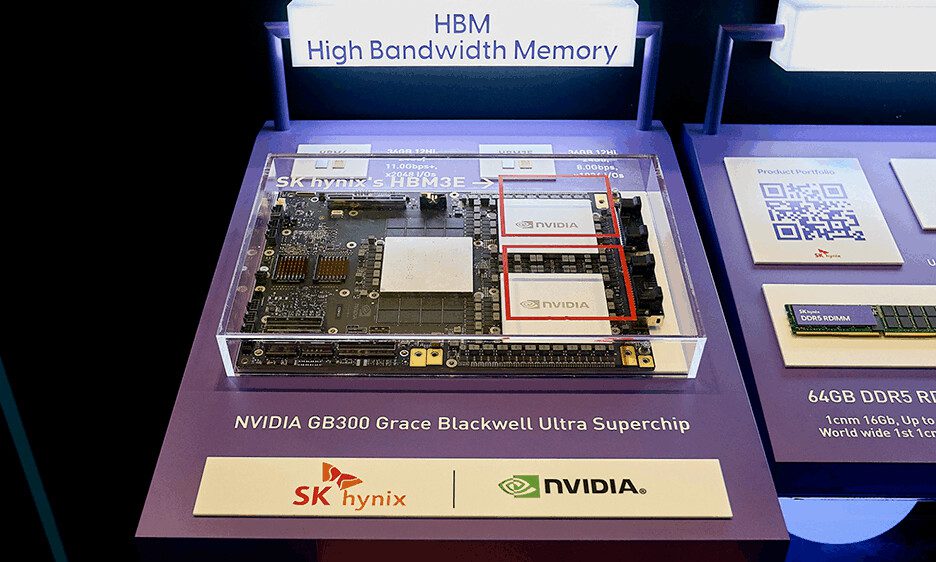

Pameran Teknologi: HBM4, AI DRAM, dan Sistem LLM Generasi Baru

SK hynix memamerkan serangkaian inovasi, termasuk:

- HBM4 12-layer, dengan bandwidth dan efisiensi daya yang dibutuhkan AI komputasi ultra-tinggi

- HBM3E 36 GB pada NVIDIA GB300 Grace Blackwell Superchip

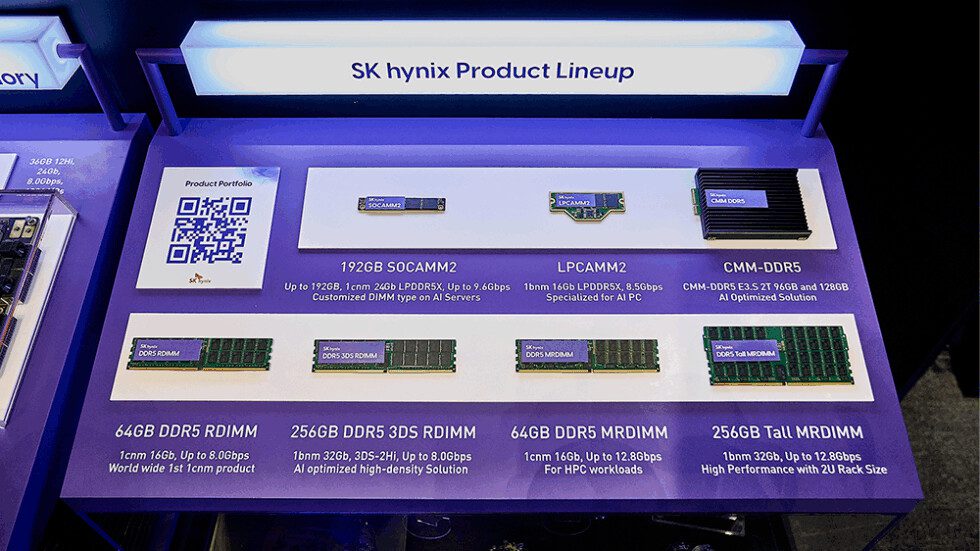

- DRAM generasi baru: RDIMM/MRDIMM 256 GB, SOCAMM2, LPCAMM2, CXL CMM-DDR5

- Sistem LLM inference terdistribusi dengan pooled memory berbasis CXL

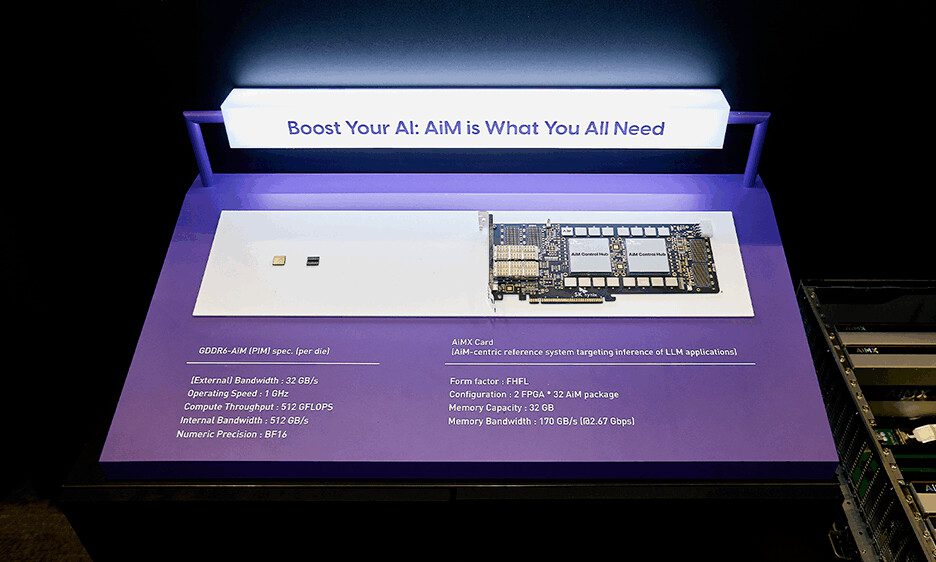

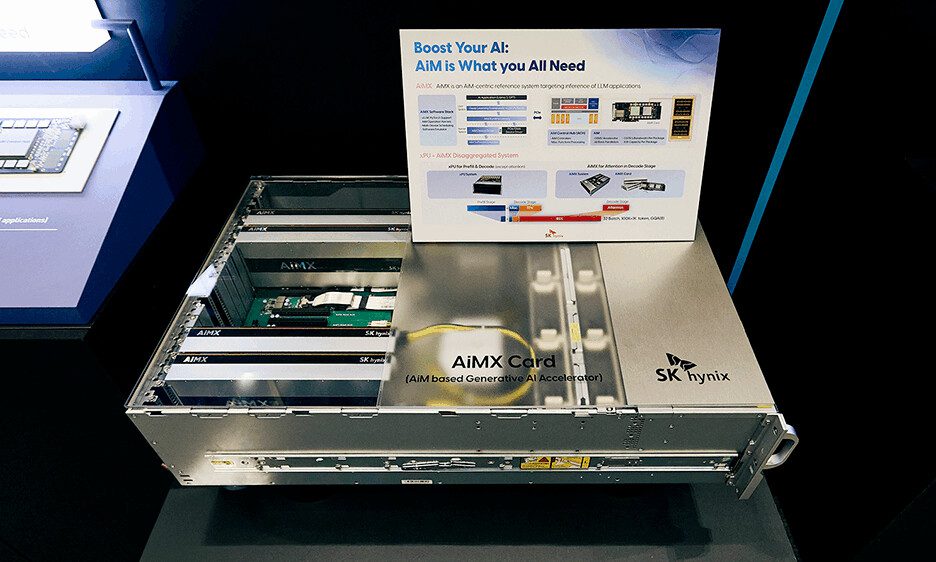

- AiMX, yang meningkatkan kecepatan operasi memory-bound pada GPU NVIDIA H100

- eSSD performa tinggi seperti PS1010 E3.S dan PS1101 E3.L

- Sistem pendeteksi notch wafer berbasis YOLOv8-OBB

Pada penutupan acara, CEO Kwak menegaskan komitmen SK hynix untuk memimpin memori AI melalui kolaborasi global dan inovasi berkelanjutan:

“Kami akan merintis masa depan AI memory bersama pelanggan, mitra, dan seluruh ekosistem.”

Sumber: SK hynix